在当今信息爆炸的时代,数据处理已成为各行各业不可或缺的核心技能。Python凭借其简洁的语法、强大的生态系统和丰富的库支持,成为数据科学和数据处理领域的首选语言。无论是数据清洗、转换、分析还是可视化,Python都能提供高效、灵活的解决方案。

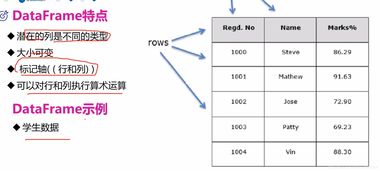

Python处理数据的基石在于其强大的库。NumPy提供了高性能的多维数组对象和数学函数,是科学计算的基础。Pandas则构建于NumPy之上,提供了DataFrame和Series等数据结构,使得数据清洗、筛选、聚合和转换变得异常简单。对于大型数据集,Pandas可以高效处理,而结合Dask等库,甚至可以扩展到分布式计算环境。

数据清洗是数据处理的第一步,也是至关重要的一步。现实世界的数据往往存在缺失值、异常值、重复记录等问题。Pandas提供了丰富的方法来处理这些挑战。例如,使用dropna()或fillna()处理缺失值,通过drop_duplicates()去除重复行,利用条件筛选识别和修正异常值。字符串处理库如re(正则表达式)和Pandas的字符串方法可以帮助清洗和标准化文本数据。

数据转换与整合同样重要。Pandas的merge()和concat()函数能够轻松合并多个数据集,而groupby()操作则支持按特定维度分组并进行聚合计算(如求和、均值、计数等)。对于时间序列数据,Pandas提供了强大的时间处理功能,包括日期解析、重采样、滑动窗口计算等。

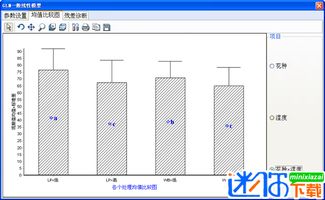

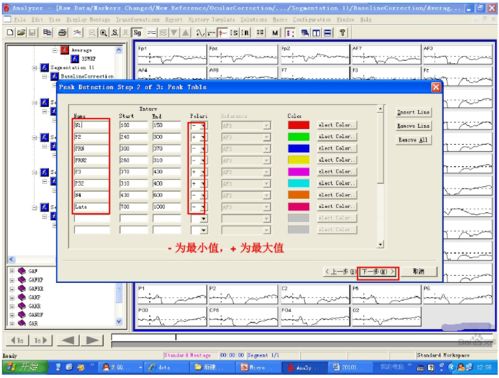

在数据分析阶段,Python的统计和机器学习库大显身手。SciPy和StatsModels支持高级统计分析,而Scikit-learn则提供了完整的机器学习工具链,涵盖分类、回归、聚类等多种算法。通过Matplotlib、Seaborn和Plotly等可视化库,可以将分析结果以图表形式直观呈现,帮助洞察数据背后的规律和趋势。

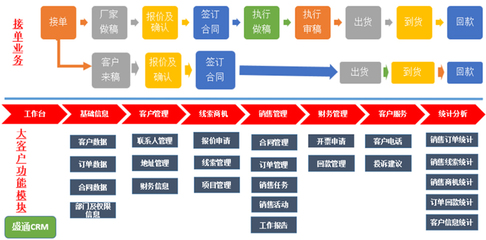

数据处理流程的自动化是提升效率的关键。结合Jupyter Notebook进行交互式开发,或使用脚本和自动化工具(如Airflow)构建数据处理管道,可以实现从数据采集、清洗、分析到报告生成的全流程自动化。

Python以其全面的库支持和活跃的社区,为数据处理提供了从入门到精通的完整路径。掌握Python数据处理技能,不仅能提升工作效率,更能为数据驱动的决策提供坚实支持。无论是初学者还是有经验的开发者,都可以在Python的生态中找到适合自己的工具和方法,解锁数据的无限价值。